大曲因其在酿酒过程中的糖化、发酵和生香功能,是影响酿酒产量和品质的关键因素[1-4]。五粮液大曲因其独特外观而得名“包包曲”,浓香型白酒五粮液因其独特的风味和卓越的品质在国内外享有盛誉,而五粮液包包曲作为关键发酵原料,在酒体风味形成和品质控制方面起着至关重要的作用[5-11]。包包曲的质量直接影响白酒的发酵过程和最终产品的风味特征[2],因此,准确、高效地识别包包曲的截面特征并进行分级,对于酿酒质量的稳定和标准化生产至关重要。

传统的包包曲分级主要依赖人工观察和经验判断,工程师通常通过观察包包曲截面的颜色、纹理、形态并结合感官和理化指标来进行分级检验[2]。例如,包包曲的感官鉴定特征包括:曲香纯正,气味浓郁;“穿衣”良好,断面整齐,菌丝粗壮紧密,以猪油白色或乳白色为主;兼有少量黄色[2]。然而,传统鉴定方法存在以下问题:a)主观性强,稳定性不足:不同专业程度的工程师对包包曲特征的理解和判断可能存在差异,导致分级结果稳定性有所不足,而优秀工程师的培养周期长;b)效率较低,难以规模化:人工检测速度较慢,在面临大规模生产需求时存在挑战。

近年来,深度学习在计算机视觉领域取得了突破性进展,并在食品质量检测、医疗影像分析、图纸分析等领域展现出优越的识别能力[12-17]。其中,深度卷积神经网络在农业与食品工业中的应用也得到了广泛验证[18],例如,用于作物病害检测和食品质量分级等任务[19]。LUO等[20]基于卷积神经网络实现了杂草种子的图像识别。张茹等[21]基于计算机视觉实现了生鲜牛肉冷藏时间的识别。

因此,本研究提出了一种基于深度学习方法的包包曲分级框架,以实现包包曲分级的智能化和高效化,主要包括:构建高质量包包曲数据集:采集并标注大量包包曲截面图像,建立标准化数据集,为模型训练提供数据支持。设计两阶段深度学习模型:第一阶段采用目标检测模型识别包包曲截面,第二阶段利用图像分类模型对识别出的截面进行分级判别。优化模型性能与部署策略:通过实验分析不同超参数组合、网络结构及图像分辨率对模型性能的影响,最终选定最优方案,并在测试集中进行案例验证。

1 基于深度学习的五粮液包包曲的分级框架

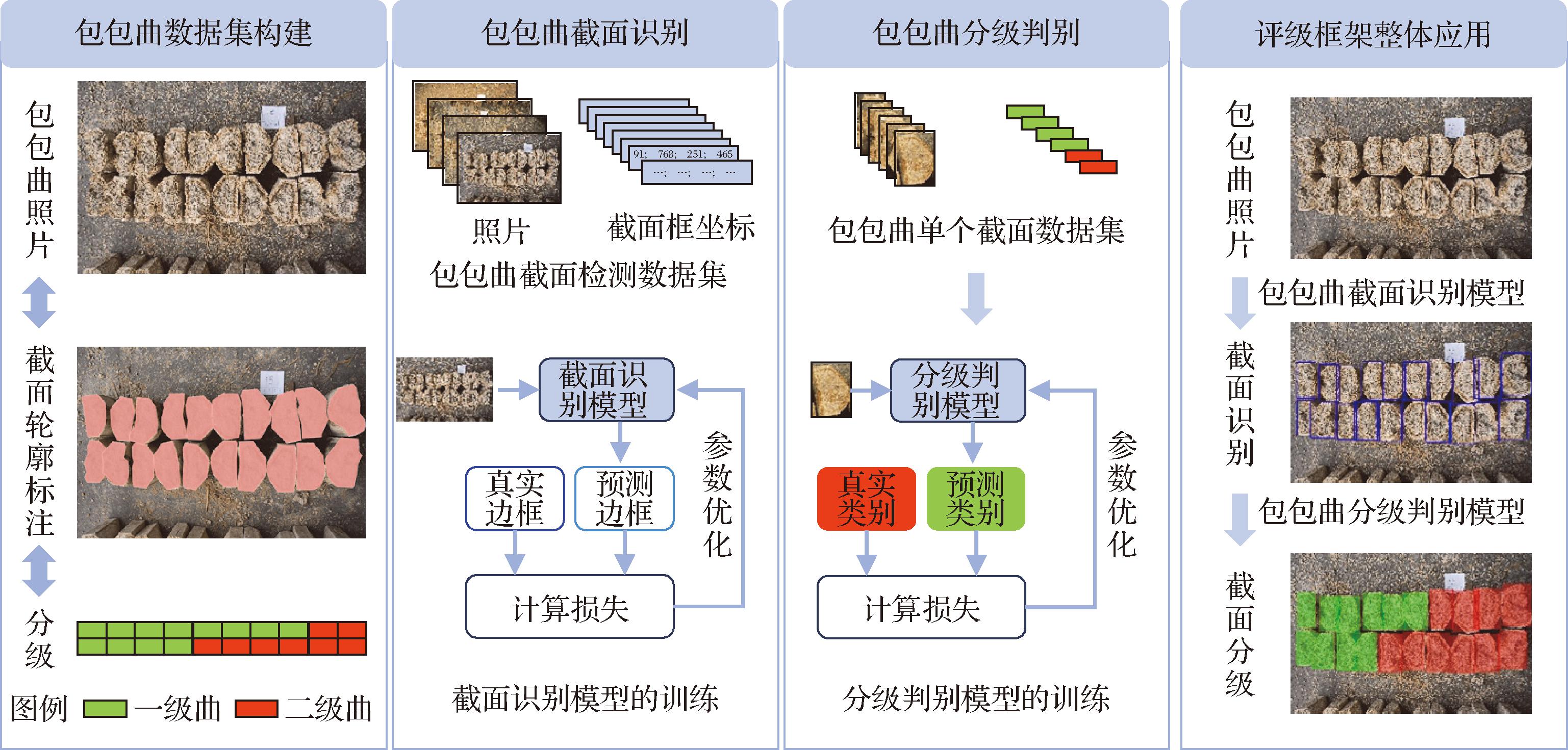

本研究提出了一种基于深度学习的五粮液包包曲分级框架,旨在实现包包曲的智能化识别和标准化分级。如图1所示,该框架主要由包包曲数据集构建、包包曲截面识别、包包曲分级判别、分级框架的整体应用4个关键部分组成。通过这一框架,可以有效提升包包曲分级的准确性和一致性,减少人工判断的主观性,提高酿酒工业的自动化和智能化水平。本节对整个分级框架的流程进行介绍,具体的实验分析和模型性能讨论将在第2节展开。

图1 基于深度学习的五粮液包包曲分级框架

Fig.1 The grading framework for Wuliangye Baobaoqu based on deep learning

1.1 包包曲数据集构建

数据集的质量直接影响深度学习模型的性能。为了确保模型能够有效学习包包曲的截面特征并实现准确分类,本研究建立了一个高质量的数据集,涵盖截面识别与分级判别2项任务。

数据采集方面,采用索尼 ILCE-7M4相机和SEL2470GM2镜头,在标准光照条件下拍摄包包曲截面图像。所有拍摄均由人工在受控环境下进行,以确保光照、角度和空间分辨率的统一性。每张图像包含10块包包曲,共20个截面,并采用高分辨率存储,以便捕捉截面纹理的细微差异。

数据标注采用Label Studio工具进行手动标注。标注过程中,依据包包曲的实际轮廓,对截面区域进行精准的多边形标注,并以COCO(Common Objects in Context)数据格式导出,以确保与目标检测任务的兼容性[22]。

在类别划分方面,为确保数据的均衡性和分类的稳定性,本研究仅考虑工业生产中占比最高的一级曲和二级曲,由经验丰富的车间工程师逐块进行人工分级标注,确保类别标签的准确性。最终,数据集构建完成,形成标准化的“图像—截面标注—截面类别”映射关系,为后续模型训练提供数据基础。

1.2 包包曲截面识别模块

截面识别是本研究提出的框架的第一阶段,旨在从完整的包包曲图像中精准检测所有截面位置。由于该任务本质上属于目标检测问题,本研究采用深度神经网络进行处理。在该模块中,输入为完整的包包曲图像,输出为图像中所有包包曲截面的矩形边界框。模型通过学习大量标注数据,能够自动识别包包曲的截面轮廓,并在图像中进行框定,以便后续的分级判别任务。

该模块的有效性决定了后续分级任务的精度,因此,目标检测模型的选择至关重要。本研究选取了多个主流目标检测算法进行探索,其中包括Faster R-CNN[12]和RetinaNet[13],具体的对比实验将在第2节进行。

1.3 包包曲分级判别模块

在完成截面识别后,需要进一步对各个截面进行分级判别,以确定其属于一级曲还是二级曲。本任务属于典型的图像分类问题,通过深度学习模型对截面图像进行特征提取,并输出相应类别。在数据预处理中,截面图像被统一缩放至适当尺寸,同时采用黑色背景填充,以保留其原始的空间比例,避免图像变形对分类结果的影响。

深度学习模型在训练过程中,自动学习包包曲截面的颜色、纹理等关键特征,以区分不同等级的包包曲。为了提高模型的泛化能力,研究中探讨了多种卷积神经网络结构,包括ResNet 18[23]、ConvNeXt[24]和EfficientNet B0[25],并结合不同的训练策略进行优化。具体的模型对比、参数调整及性能评估将在第2节展开。

1.4 分级框架的整体应用

本研究最终实现了端到端的包包曲分级框架,涵盖从图像输入到分级结果输出的完整流程。在实际应用中,首先输入完整的包包曲照片,截面识别模型自动检测所有包包曲截面,并输出其矩形边界框。之后,分级判别模型对识别出的截面区域进行特征提取,并预测其所属类别(一级曲或二级曲)。之后,输出完整的分级结果,可用于辅助生产环节的质量控制和决策。

2 分析讨论

在本研究中,于2024年12月至2025年2月期间共收集五粮液包包曲照片数据228张,其中随机取20张作为验证集,另取20张作为测试集,以供后续案例研究,余下的188张作为训练集。如1.1节所述,每一张包包曲照片数据包括10块包包曲共20个截面的数据,并按照每个截面的外轮廓进行了数据标注,并由经验丰富的车间工程师对每一块包包曲的级别进行了判别。本研究基于GeForce RTX 4090 24 GB显存的GPU进行训练,所使用设备的内存为128 GB。下面将对截面识别模块和分级判别模块展开讨论。

2.1 截面识别性能评估

截面识别模块旨在对包包曲照片中的包包曲截面进行目标检测识别。如第1节所述,包包曲照片和截面标注用于构建包包曲截面识别模块,具体地,根据包包曲截面的多边形轮廓标注生成外接矩形,以作为截面识别的目标框。在本研究中,每张包包曲照片均包含有20个包包曲截面,分属于10块包包曲,其在照片平面布置中是较为规整的。鉴于本研究仅识别包包曲截面这一类目标,因此,在神经网络训练过程中,仅考虑包包曲截面和背景信息2种类别。在本研究中,采用当交并比(intersection over union,IoU)阈值取为0.75时的平均精度(average precision,AP)来评估模型效果,记为AP75。

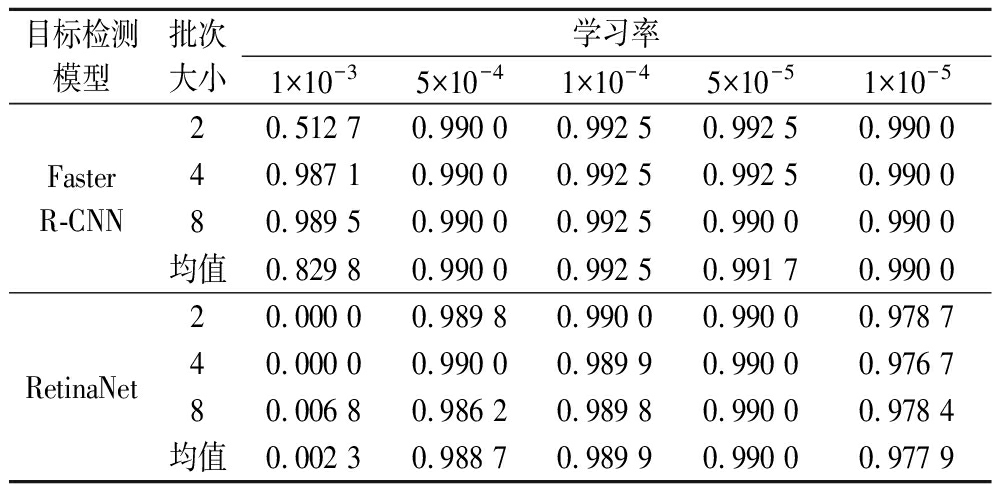

本研究讨论了目标检测中常用的Faster R-CNN模型[12]与RetinaNet模型[13]在包包曲截面检测中的效果,探讨了批次大小分别为2、4、8,学习率分别为1×10-3、5×10-4、1×10-4、5×10-5、1×10-5的工况,各工况下验证集AP75指标如表1所示。

表1 截面识别神经网络对应验证集的AP75指标

Table 1 AP75 of the cross-section recognition network on the validation set

目标检测模型批次 大小学习率1×10-35×10-41×10-45×10-51×10-5Faster R-CNN20.512 70.990 00.992 50.992 50.990 040.987 10.990 00.992 50.992 50.990 080.989 50.990 00.992 50.990 00.990 0均值0.829 80.990 00.992 50.991 70.990 0RetinaNet20.000 00.989 80.990 00.990 00.978 740.000 00.990 00.989 90.990 00.976 780.006 80.986 20.989 80.990 00.978 4均值0.002 30.988 70.989 90.990 00.977 9

由表1可得,在学习率取1×10-4时,目标检测模型Faster R-CNN在批次大小为2、4、8时均具有最优的验证集AP75指标,且针对不同批次大小计算的AP75指标均值最高。而RetinaNet网络整体上比Faster R-CNN网络略差。因此,使用目标检测模型Faster R-CNN及学习率1×10-4进行后续案例研究。由于不同批次大小对学习率取1×10-4时Faster R-CNN模型的AP75指标无影响,因此,后续案例研究中选取批次大小为2对应的模型。

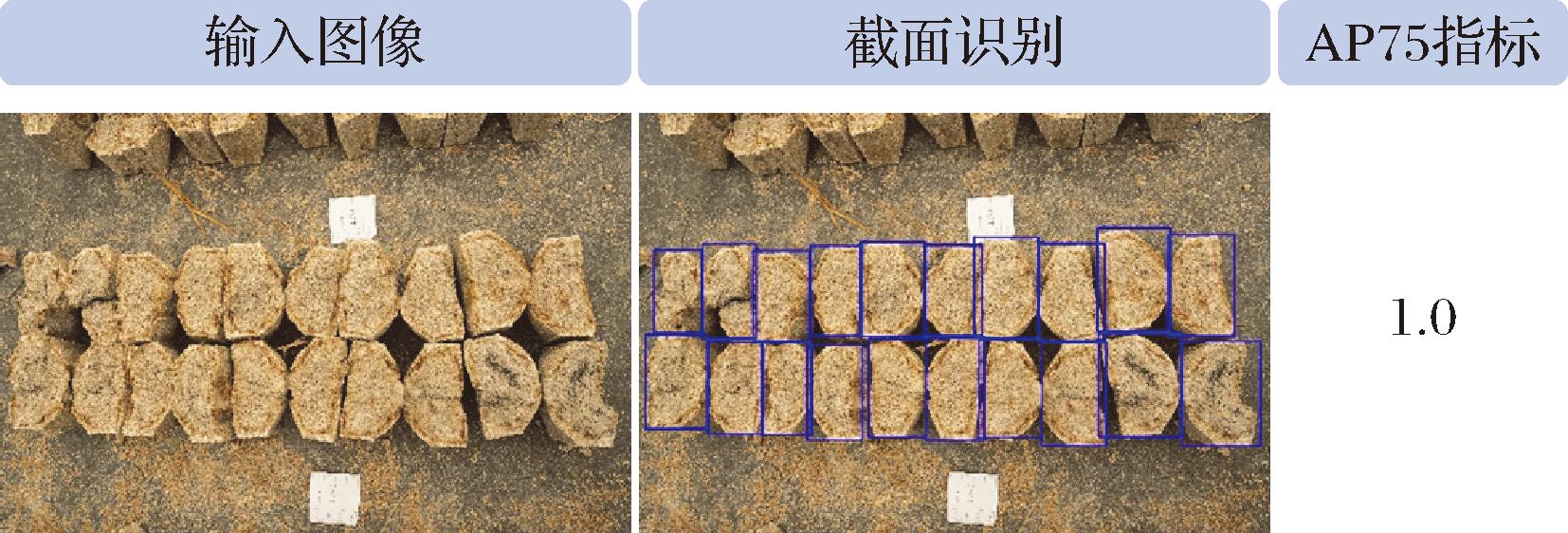

图2展示了验证集中一个包包曲照片案例的包包曲截面识别结果,该案例对应的AP75指标为1.0。

图2 验证集中一个案例的包包曲截面识别结果

Fig.2 Example result of Baobaoqu cross-section recognition on the validation set

2.2 分级判别性能分析

在分级识别模块,188张包包曲照片的训练集共包括3 760个包包曲截面,20张包包曲照片的验证集共包括400张包包曲截面。为保持包包曲截面正确的空间比例,将矩形的包包曲截面居中放置在黑色正方形背景中,在照片缩放时,采用相同比例缩放照片的2个分辨率维度。按照卷积神经网络常用的照片分辨率尺寸,本研究考虑128×128、256×256、512×512三种常用的分辨率。

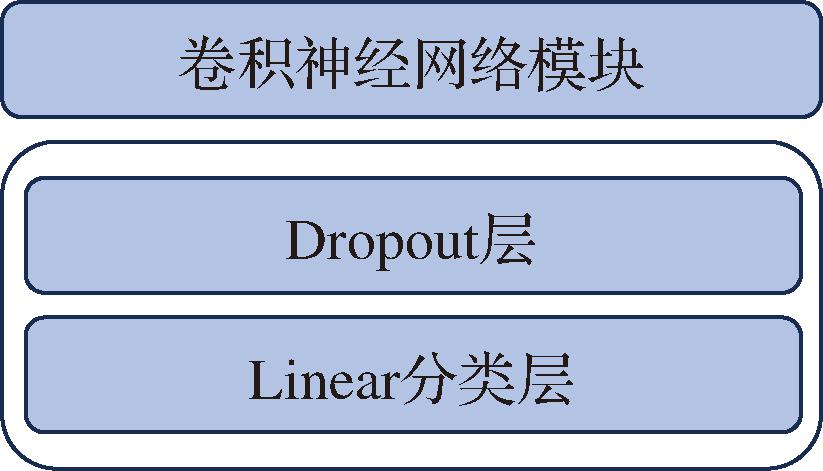

本研究中,采用深度卷积神经网络与多层感知机(multilayer perceptron,MLP)网络组合的形式实现包包曲截面的分类任务,如图3所示。ResNet[23]、ConvNeXt[24]、EfficientNet[25]是图像分类任务中常用的卷积神经网络模型。因此,本研究考虑3种神经网络模型,包括ResNet 18,ConvNeXt,EfficientNet B0,所述神经网络架构基于PyTorch深度学习平台构建。

图3 分级判别模块神经网络架构

Fig.3 Neural network architecture of the grading classification module

数据增广在神经网络训练中是增强网络鲁棒性的常用方法,在本研究中,数据增广包括:

a)±10°以内的随机旋转;

b)在水平方向和垂直方向上±5%以内的随机平移;

c)以50%的概率进行透视变换,控制畸变缩放因子distortion_scale为0.2;

d)随机裁剪原图尺寸的80%~100%,并且控制裁剪区域的宽高比为0.9~1.1,之后再将其缩放到原始尺寸,以使得图像略有变化;

e)以50%的概率水平翻转图像,以50%的概率垂直翻转图像;

f)将图像的饱和度、对比度、亮度在±10%以内随机调整,色调在±5%以内随机调整。

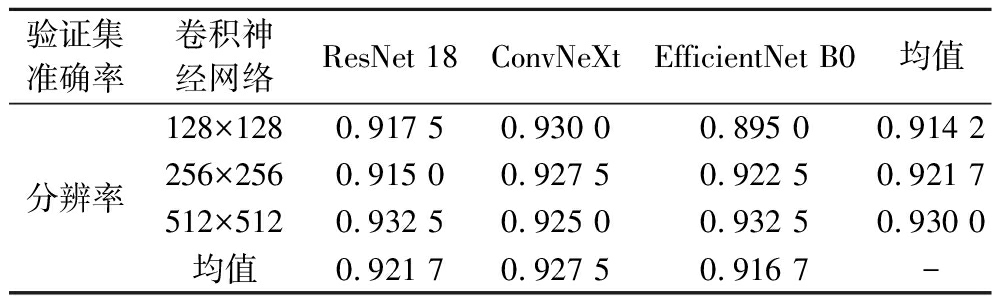

本研究所讨论的3种不同模型和3种不同分辨率对应的验证集准确率结果如表2所示。总体而言,各模型以及分辨率对应的验证集准确率相差较小,最大值和最小值相差0.037 5。其中,分辨率512×512对应的ResNet 18网络和EfficientNet B0网络的验证集准确率最高,为0.932 5。

表2 分级判别模块对应不同模型及不同分辨率的验证集准确率

Table 2 Validation accuracy of the grading classification module for different models and resolutions

验证集准确率卷积神经网络ResNet 18ConvNeXtEfficientNet B0均值分辨率128×1280.917 50.930 00.895 00.914 2256×2560.915 00.927 50.922 50.921 7512×5120.932 50.925 00.932 50.930 0均值0.921 70.927 50.916 7-

此外,根据表2中的均值可得,对于不同的卷积神经网络,512×512对应的准确率均值最高(0.930 0),这说明512×512分辨率具有较强的网络适应性;而对于不同的分辨率,ConvNeXt网络具有较强的图片分辨率的适应性。这对于实际工业应用具有一定的指导意义,在单个包包曲截面采样精度不足512×512时,采用ConvNeXt网络仍然可获得较高的准确率。

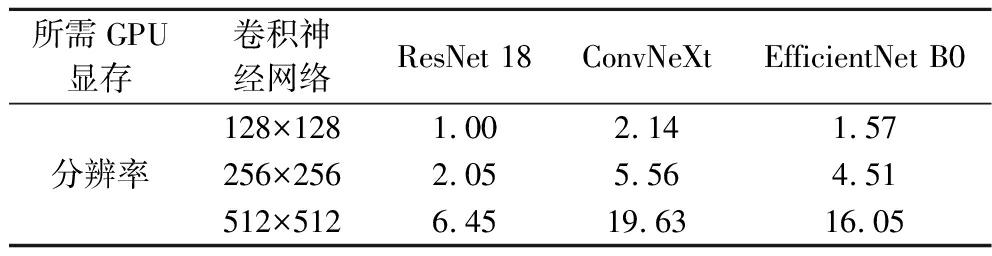

表3展示了3种不同模型和3种不同分辨率对应的分级判别模块在训练时所需的显存,批次大小使用32,可得,在512×512分辨率下,尽管ResNet 18网络和EfficientNet B0网络具有相同的准确率,但是ResNet 18网络所需显存(6.45 GB)远低于EfficientNet B0网络(16.05 GB),因此,本研究选用512×512分辨率及ResNet 18网络。

表3 分级判别模块对应不同模型及不同分辨率在训练时所需GPU显存 单位:GB

Table3 GPU memory consumption during training of the grading classification module across different models and input resolutions

所需GPU显存卷积神经网络ResNet 18ConvNeXtEfficientNet B0分辨率128×1281.002.141.57256×2562.055.564.51512×5126.4519.6316.05

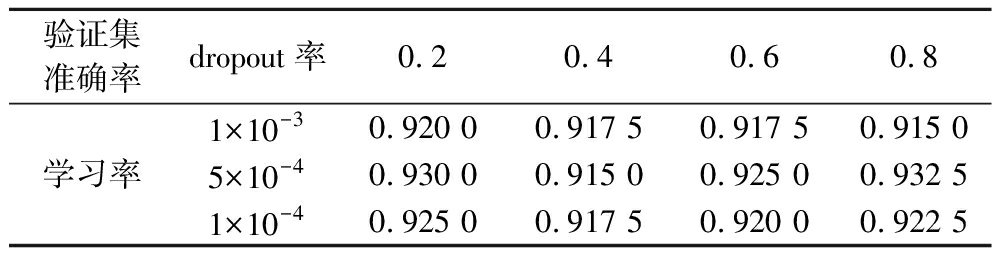

此外,dropout率和学习率也是影响神经网络效果的关键指标。因此,以表2中准确率最高的512×512空间分辨率与ResNet 18网络的组合为例展开讨论,分别取dropout率为0.2、0.4、0.6、0.8,以及分别取学习率为1×10-3、5×10-4、1×10-4,表4展示了上述工况的验证集准确率。

表4 分级判别模块对应不同dropout率和学习率的验证集准确率

Table 4 Validation accuracy of the grading classification module under different dropout and learning rates

验证集准确率dropout率0.20.40.60.8学习率1×10-30.920 00.917 50.917 50.915 05×10-40.930 00.915 00.925 00.932 51×10-40.925 00.917 50.920 00.922 5

从表4可以看出,学习率5×10-4和dropout率0.8的组合是最优的(验证集准确率0.932 5),这也是表3中所使用的模型参数。因此,在案例研究中,本研究将使用512×512分辨率下的ResNet 18网络,且学习率取5×10-4、dropout率取0.8。

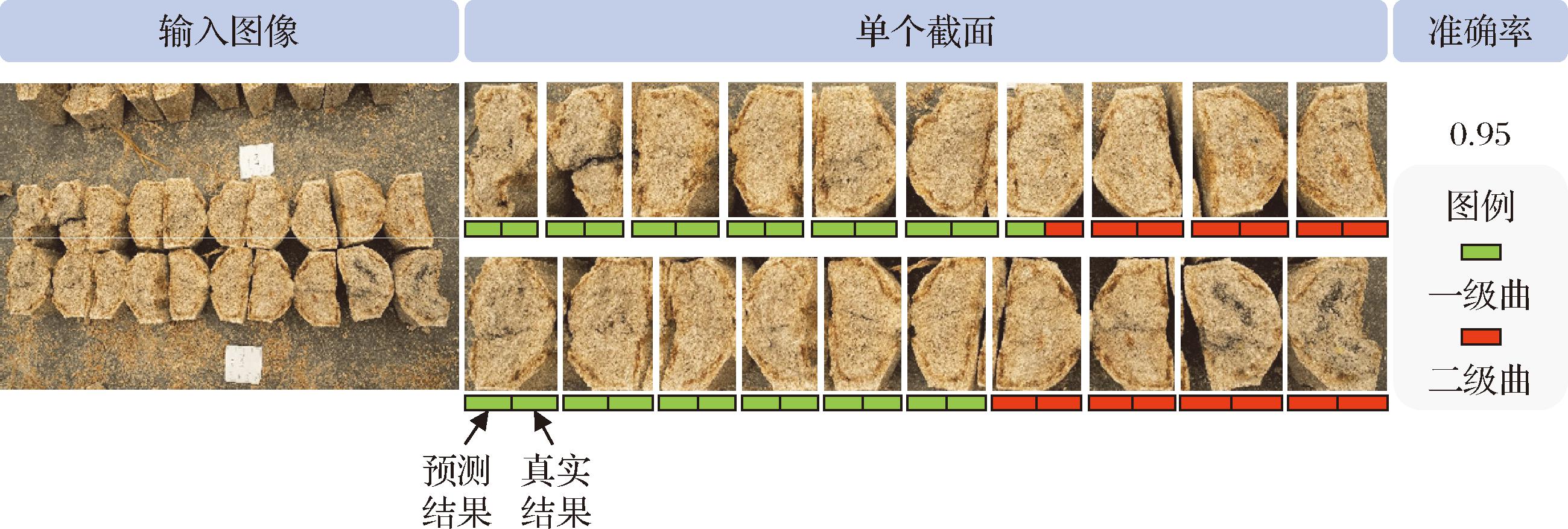

图4展示了与2.1节中相同的验证集案例的包包曲截面分级判别结果,在该案例中,分类准确率有95%。

图4 验证集中一个案例的包包曲分级判别结果

Fig.4 Example result of Baobaoqu grading classification on the validation set

3 案例研究

如第1节所述,上述截面识别模块和分级判别模块在实际应用时,需要打通它们之间的衔接流程。首先通过截面识别模块识别一张包包曲照片中的所有的包包曲截面,继而通过分级判别模块对识别得到的每个包包曲截面进行分级判别,进而实现包包曲的分级。

在本节案例研究中,使用第2节中截面识别模块和分级判别模块选出的最优模型和超参数进行应用模型的构建,并针对测试集的20个案例进行分析。此外,在实际生产中,同一块包包曲的2个截面应属于相同的等级。因此,为了提高分级结果的稳定性和一致性,本研究在模型推理阶段引入了后处理策略,在最终分级时,属于同一块包包曲的2个截面的分类结果进行融合:将同一块包包曲的2个截面的分类输出(即模型在softmax前的原始输出,通常称为logits)取平均,再通过argmax运算判别平均值对应2个级别中的最大值对应的级别,来确定最终类别。

为方便展示,图5仅展示了测试集中5个案例的截面识别及分级判别结果,其中,绿色半透明矩形框表示一级曲,红色半透明矩形框表示二级曲。案例显示,本研究所提出方法能够精准识别图片中的包包曲截面并进行高准确率的分级判别。

图5 测试集中5个案例的截面识别及分级判别结果

Fig.5 Cross-section recognition and grading classification results for 5 cases in the test set

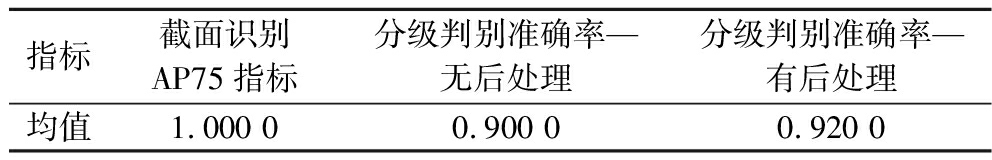

全部测试集的平均结果如表5所示。测试集的20个案例在模型的训练和验证中从未出现过,本研究所提出方法在测试集中能达到92%的准确率,说明了本研究所提出方法的可靠性。

表5 测试集中20个案例结果均值

Table 4 Average results of 20 cases in the test set

指标截面识别AP75指标分级判别准确率—无后处理分级判别准确率—有后处理均值1.000 00.900 00.920 0

4 结论与展望

本研究提出了一种基于深度学习的五粮液包包曲分级框架,以提高包包曲的识别效率和分级标准化程度。研究内容涵盖数据集构建、深度学习模型设计、实验验证及实际应用。主要结论如下:

a)构建了高质量的包包曲数据集,涵盖不同级别包包曲的截面图像,并结合工程师标注,形成标准化数据集,为智能化分级奠定基础。

b)提出了一种两阶段深度学习框架,第一阶段采用目标检测模型(Faster R-CNN、RetinaNet)实现包包曲截面识别,第二阶段采用深度卷积神经网络(ResNet 18、ConvNeXt、EfficientNet B0)进行截面分类,确保高精度分级。

c)实验结果表明,所提出方法能够有效提升包包曲的自动化分类效率,在测试集中取得媲美人工分级的准确率。此外,模型优化实验表明,ResNet 18在512×512分辨率下的性能最优,且计算资源需求较低,适用于实际工业应用。

d)引入后处理策略优化分级的稳定性,采用同一块包包曲2个截面分类结果的融合策略,进一步提高分级的鲁棒性。

尽管本研究提出的方法在包包曲分级任务中表现良好,但仍存在以下值得进一步优化的方向:

a)数据集扩展与增强:目前数据集中仅包含一级曲和二级曲,未来可增加三级曲样本,并进一步增加数据集大小。

b)多模态融合:未来可结合电子鼻、红外成像等技术,以提升模型对复杂样本的识别能力。

c)多季节特征分析:未来可考虑不同季节的包包曲数据采集,充分分析季节对包包曲截面特征的影响,提升模型的季节适应性。

本研究为白酒酿造工业提供了一种高效的包包曲分级框架,为提升酿酒过程的数字化和智能化水平提供了技术支持。未来,随着数据和算法的不断优化,该方法有望进一步推广,以推动白酒行业传统发酵工艺的智能化升级。

[1] 沈怡方. 白酒生产技术全书[M].北京:中国轻工业出版社, 2015.SHEN Y F.Encyclopedia of Baijiu Production Technology[M].Beijing:China Light Industry Press, 2011.

[2] 赵东, 杨韵霞.探秘五粮液:酿造·品质·科技[M].北京:化学工业出版社, 2022.ZHAO D, YANG Y X.The Secrets of Wuliangye:Brewing, Quality, Technology[M].Beijing:Chemical Industry Press, 2022.

[3] 黄平, 王子豪, 郑佳, 等.浓香型白酒大曲微生物群落结构研究进展[J].微生物学通报, 2023, 50(7):3170-3186.HUANG P, WANG Z H, ZHENG J, et al.Research progress in microbial community structure in Nongxiangxing Daqu[J].Microbiology China, 2023, 50(7):3170-3186.

[4] 杨雯净, 李煜滋, 黄丹, 等.浓香型白酒大曲产α-淀粉酶芽孢杆菌的分离鉴定及代谢特性研究[J].中国酿造, 2025, 44(2):80-86.YANG W J, LI Y Z, HUANG D, et al.Isolation, identification and metabolic characteristic of α-amylase-producing Bacillus from strong-flavor Baijiu Daqu[J].China Brewing, 2025, 44(2):80-86.

[5] 赵东, 张晓莲, 陈双为, 等.五粮液“包包曲” 的特点及常见病害的剖析防治[J].酿酒科技, 2015(12):53-56.ZHAO D, ZHANG X L, CHEN S W, et al.Features of wrapped starter of Wuliangye and prevention &control of its common disease[J].Liquor-Making Science &Technology, 2015(12):53-56.

[6] 钟莉, 郑佳, 彭志云, 等.五粮液“包包曲” 的生产特点和展望[J].酿酒科技, 2017(6):37-43.ZHONG L, ZHENG J, PENG Z Y, et al.Production and development prospects of Wuliangye bulgy Daqu[J].Liquor-Making Science &Technology, 2017(6):37-43.

[7] 郑佳, 赵东, 何张兰, 等.利用GC×GC-TOFMS鉴定包包曲中的游离香气成分[J].酿酒科技, 2021(11):17-24;30.ZHENG J, ZHAO D, HE Z L, et al.Identification of free aroma compounds in bulgy Daqu by GC×GC-TOFMS[J].Liquor-Making Science &Technology, 2021(11):17-24;30.

[8] 罗青春, 郑佳, 赵东, 等.浓香型白酒中优势乳酸菌和酵母菌间的相互关系[J].应用与环境生物学报, 2019, 25(5):1192-1199.LUO Q C, ZHENG J, ZHAO D, et al.Interaction between dominant lactic acid bacteria and yeasts strains in strong aroma Baijiu[J].Chinese Journal of Applied and Environmental Biology, 2019, 25(5):1192-1199.

[9] 雷学俊, 张霞, 刘多涛, 等.包包曲及制曲环境中可培养霉菌的分离与鉴定[J].酿酒科技, 2019(12):17-22.LEI X J, ZHANG X, LIU D T, et al.Isolation and identification of cultivable mold strains from bulgy Daqu and Daqu-making environment[J].Liquor-Making Science &Technology, 2019(12):17-22.

[10] 张倩, 韩保林, 李子健, 等.浓香型白酒包包曲微生物种群多样性及形成机制[J].食品与发酵工业, 2021, 47(18):99-106.ZHANG Q, HAN B L, LI Z J, et al.Diversity and formation mechanism of the microflora in strong flavor Baijiu Baobaoqu[J].Food and Fermentation Industries, 2021, 47(18):99-106.

[11] 陈勇, 林涵瑞, 陈晓茹, 等.川派浓香型白酒大曲的典型产区差异性分析[J].中国酿造, 2024, 43(11):34-40.CHEN Y, LIN H R, CHEN X R, et al.Difference analysis of Sichuan strong-flavor Baijiu Daqu in typical producing areas[J].China Brewing, 2024, 43(11):34-40.

[12] REN S Q, HE K M, GIRSHICK R, et al.Faster R-CNN:Towards real-time object detection with region proposal networks[C].IEEE Transactions on Pattern Analysis and Machine Intelligence.IEEE, 2017:1137-1149.

[13] LIN T Y, GOYAL P, GIRSHICK R, et al.Focal loss for dense object detection[C].2017 IEEE International Conference on Computer Vision (ICCV).IEEE, 2017:2999-3007.

[14] LECUN Y, BENGIO Y, HINTON G.Deep learning[J].Nature, 2015, 521(7553):436-444.

[15] KRIZHEVSKY A, SUTSKEVER I, HINTON G E.ImageNet classification with deep convolutional neural networks[C].Annual Conference on Neural Information Processing Systems.USA:Stateline, 2012.

[16] ZHAO P J, LIAO W J, HUANG Y L, et al.Intelligent design of shear wall layout based on attention-enhanced generative adversarial network[J].Engineering Structures, 2023, 274:115170.

[17] 丁浩晗, 田嘉伟, 谢祯奇, 等.机器学习和大数据在食品领域的应用[J].食品与发酵工业, 2024, 50(24):353-361.DING H H, TIAN J W, XIE Z Q, et al.Applications of machine learning and big data in food industry[J].Food and Fermentation Industries, 2024,50(24):353-361.

[18] ZHOU L, ZHANG C, LIU F, et al.Application of deep learning in food:A review[J].Comprehensive Reviews in Food Science and Food Safety, 2019, 18(6):1793-1811.

[19] KAMILARIS A, PRENAFETA-BOLD F X.Deep learning in agriculture:A survey[J].Computers and Electronics in Agriculture, 2018, 147:70-90.

F X.Deep learning in agriculture:A survey[J].Computers and Electronics in Agriculture, 2018, 147:70-90.

[20] LUO T Y, ZHAO J Y, GU Y J, et al.Classification of weed seeds based on visual images and deep learning[J].Information Processing in Agriculture, 2023, 10(1):40-51.

[21] 张茹, 张奋楠, 周星宇, 等.基于机器视觉的生鲜牛肉冷藏时间识别研究[J].食品与发酵工业, 2022, 48(18):75-80.ZHANG R, ZHANG F N, ZHOU X Y, et al.Identification of the refrigerated time for chilled beef based on machine vision[J].Food and Fermentation Industries, 2022, 48(18):75-80.

[22] LIN T Y, MAIRE M, BELONGIE S, et al.Microsoft COCO:Common objects in context[C].Computer Vision- ECCV 2014.Cham:Springer, 2014:740-755.

[23] HE K M, ZHANG X Y, REN S Q, et al.Deep residual learning for image recognition[C].2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR).IEEE, 2016:770-778.

[24] LIU Z, MAO H Z, WU C Y, et al.A ConvNet for the 2020 s[C].2022 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR).IEEE, 2022:11966-11976.

[25] TAN M, LE Q.EfficientNet:Rethinking model scaling for convolutional neural networks[C].Proceedings of Machine Learning Research.USA:Long Beach, 2019.